如果你发现你的网站放开后却久久不被抓取收录,或者被收录的网页少之又少,那么,需要注意了,也许,你的网站进行了阻碍搜索引擎爬取和收录网站/网页的设置,如何检查呢?

第一步,排查Robots.txt文件。

先科普一下何为Robots.txt文件?

Robots.txt文件是位于 WordPress 根目录中的文本文件,它用于让搜索引擎机器人知道您网站上的哪些页面应该被抓取,哪些不应该被抓取。一个带有正确指令的 Robots.txt文件既可以防止爬虫抓取不必要的内容外,又可确保抓取配额(在给定时间内爬虫可以抓取网站的最大次数)不会浪费。

Ok.,大家Get了吧?简单一句话,Robots.txt就是为了告诉爬虫应该或不应该爬取你网站的哪些部分。

那么,如何自查网站的Robots.txt文件?CiCi教大家一个简单的方法:

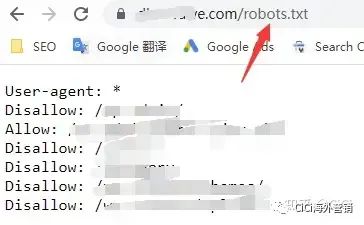

打开浏览器,直接在地址栏里输入:你的域名+robots.txt,如下图所示。

Allow就是允许被爬取的网页,Disallow就是不允许被爬取的网页。

前几天刚接了一个客户,他说网站做完一年多了,一直没有被收录,我一检查,唉,简直大无语了,他的robots.txt是这样的:

User-agent: *

disallow: /

来,给大家当下翻译:

user-agent 是用户代理的意思,行中的星号代表任意爬虫的意思,也就是所有可能的爬虫都要按照robots文件中的要求进行合理的抓取网站中的文件、目录;

disallow行中的正斜杠就是告诉告诉爬虫,这个网站的所有网页都禁止被爬取。

So,这个网站robots.txt的设置就是禁止所有爬虫爬取所有网页,这?简直就是大写加粗的难受呀!我的客户白白浪费掉了一年多的宝贵时间,它本来有很多机会获取排名和流量的,可惜,可恨!

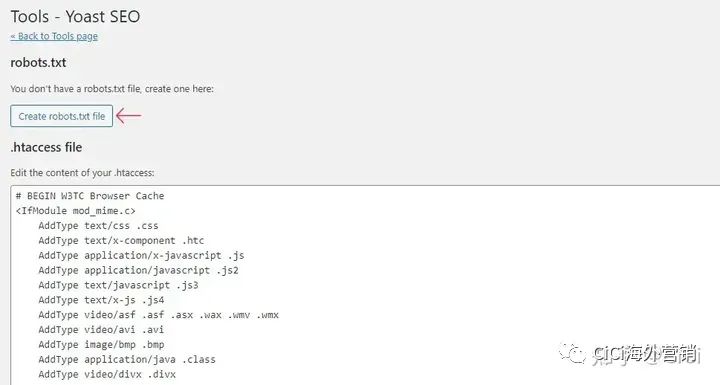

如何设置Robots.txt文件呢?不懂代码的也不要愁,毕竟CiCi擅长帮大家把复杂的事情简单化,我们可以用几个简单的Wordpress插件来搞定:Yoast SEO。

Yoast SEO拥有超过 500 万的活跃安装,是最受欢迎的 SEO 插件之一。它有很多站点优化工具,包括允许用户创建和编辑 robots.txt 文件的功能。

插件安装后,点击SEO模块,点击Tools,选择File Editor,然后点击create robots.txt file按钮并进行编辑保存。

类似的插件还有All in one SEO,大家自由选择啦。

By the way,给大家分享一个测试和验证 robots.txt的工具:

https://technicalseo.com/tools/robots-txt/,它能检查 URL 是否被阻止,哪个指令阻止它以及阻止哪个用户代理。也还可以检查页面的资源(CSS、JavaScript、图像)是否被禁止爬取。

第二步,排查 Noindex 标签

有时候用的一些插件软件,会给你加一些流氓Noindex标签,或者你自己在网站编辑的时候,不小心给一些页面添加了Noindex标签。

何为Noindex标签?顾名思义,就是告诉爬虫不要索引收录的标签。

很多时候,你感觉你的网站好内容不少,但是就是不被收录,这个时候一定要敏锐一些,一旦感觉不对劲,抓紧开始自查!

如何找到带有Noindex标签的网页?CiCi教你一招,既简单又精准!

给网站安装绑定 Google Search Console,选择Overview模块,依次点击“Indexing”和“Full Report”,

然后就能看到网页不被索引的原因,其中有一个原因是Excluded by ‘noindex’ tag,即带有Noindex标签的网页,点击即可查看具体的网页,然后自己好好排查即可~

对于不应该有Noindex标签的网页,及时进入后台进行编辑修改即可。

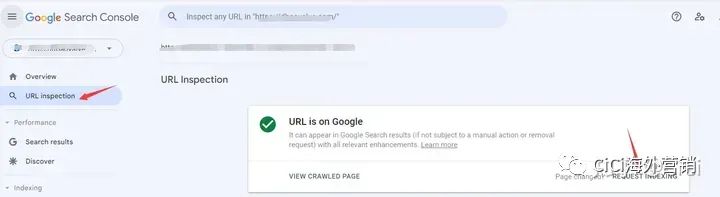

想加快索引的话,修改完标签后可以在 Google Search Console中提交一下,大家可以按照下图所示进行操作:

注意:要使noindex规则生效,页面不得被 robots.txt 文件阻止,并且爬虫必须可以访问它。如果页面被 robots.txt 文件阻止或爬虫无法访问该页面,则爬虫永远不会看到 noindex标签,那么该页面仍会出现在搜索结果中,例如,如果其他页面链接到它,它的内容仍会被编入索引。

第三步,设置站点地图(Sitemap)

Sitemap是一个文件,用于帮助搜索引擎发现你的网站页面并且确定抓取的优先级,

如果你的网站满足以下三种情况,那么你可能很需要Sitemap:

1.你的网站很大。通常,在大型网站上,要确保每个页面都至少被该网站上的一个其他页面链接起来会更加困难。因此,Googlebot 更有可能无法发现您的某些新网页。

2.你的网站是新网站,几乎没有指向它的外部链接。Googlebot 和其他网络抓取工具通过跟踪从一个页面到另一页面的链接来抓取网络。因此,如果没有其他网站链接到您的网页,Googlebot 可能不会发现它们。

3.你的网站有很多多媒体内容(视频、图片)或显示在Google News.中。 Google 可以将Google News.中的其他信息考虑到搜索中。

对于满足这些条件的网站,若没有设置Sitemap,那么 Google 很可能根本就不知道有某些页面的存在,尤其是某些重点页面,翻译成人话就是白干了,要知道,人生最喜欢的事情莫过于白嫖,最讨厌的事情莫过于白干。

如何设置Sitemap?

很简单,我们依旧可以利用Google Search Console,登录后点击Sitemaps,输入并点击SUBMIT进行提交。

第四步,排查错误的Canonical Tag。

先简单解释一下什么是Canonical Tag吧。

如果你的某个网页可通过多个网址访问,或者你的不同网页有着类似的内容(比如某个网页既有移动版,又有桌面版),那么 Google 会将这些网页视为同一个网页的重复版本。Google 会选择一个网址作为规范版本并抓取该网址,而将所有其他网址视为重复网址并降低对这些网址的抓取频率。Canonical Tag就是明确告诉谷歌应该选取哪个网页作为规范网页进行抓取收录,从而减少 Google的抓取工作量,提高主要网页的抓取收录与谷歌排名。

如果Canonical Tag用到了非主要网页上,则会出现主要页面不被抓取收录的问题。还有会造成多个重复页面的反复抓取,使网站浪费大量抓取预算,影响整个网站的收录,毕竟地主家也没有余粮啊。

关于canonical Tag的使用与注意事项,感兴趣的可以私信我。篇幅问题,这里先不详细讲设置了。

第五步,修复所有 Nofollow 内部链接

nofollow 的字面意思就是不要跟踪或索引该特定链接。如果恰巧这个网站有很多nofollow的内部链接,那就禁止了谷歌对这个网站的页面进行索引。

Nofollow和noindex都是要小心使用的。如果有大量 nofollow 链接,在谷歌眼中可能就是网站质量问题。在这种情况下,网站可能会被标记为更不自然的网站(more unnatural site),当然这取决于 nofollow 链接的严重性。

因为这些 nofollow,就是在告诉谷歌不要真正信任这些特定链接。

所以,一定要严肃对待nofollow的使用。

那就一点都不要有了吗?当然也不是。

因为我们总有很多不希望用户看到的信息,比如私人的网站管理员登录页面,我们肯定不希望用户能看到。

而且之前的谷歌,只有一种类型的 nofollow 链接,但是最近增加了 nofollow 链接的分类。

新分类包括用户生成的内容 (UGC) 和赞助广告 (ads)。

如果这个网站做大量广告或 UGC(例如博客评论),也要考虑一下是不是要加上一些nofollow。因为博客评论往往会生成大量自动垃圾邮件,现在反垃圾邮件又这么严峻,可以考虑加一下。

第六步,构建强大的内部链接

强大的内链,没错,就是强大,powerful。

普通的内链和“强大的内链”是有区别的。

普通的内部链接只是一个内部链接。加一个未必会对排名产生多大的影响。

但是,如果你本身就有很多高价值页面,流量很高,权威重,那可以通过内链联系起来。

为啥要这么做呢,看一下下面:

1、帮助用户浏览您的网站,增加网站粘性与访问深度。

2、从其他具有强权限的页面传递权限。

3、有助于定义整个网站的架构。

不过要确保它们功能强大且具有足够的价值,能帮助目标页面在搜索引擎结果中竞争才行哈。

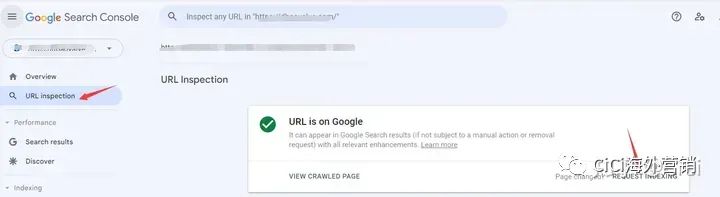

第七步,将页面提交到 Google Search Console

如果某个网页的索引有问题,可以考虑在在 Google Search Console里多提交几次,提醒谷歌的抓取与索引。

这样可以迅速把这个网页告知谷歌,相较于其他的方式,能更快地让谷歌注意到这个网页。

如果提交的这个页面没有任何质量问题的话,通常几天内就能够生成索引。

第八步,提升网站内容质量。

谷歌最关注的是用户体验。

而只有优质内容才能提供给用户好的体验,所以我们要时时刻刻重视网站每个网页的内容质量,多一些干货,少一些没用的车轱辘话。

毕竟是金子才能长久闪闪发光。

第九步,适当使用插件

最后,我们也可以适当的使用一些工具来助力网站的索引收录,比如Instant Indexing for Google等,这个就不做具体说明了,感兴趣的可以私信一起探讨。

联系CiCi请扫码加微信!

获取知识请扫码关注微信公众号!!

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复